Classification Metrics(분류 모델 지표 ) 알아보기 : TPR, FPR과 ROC Curve 사이 관계 및 AUC

|2023. 4. 28. 15:11

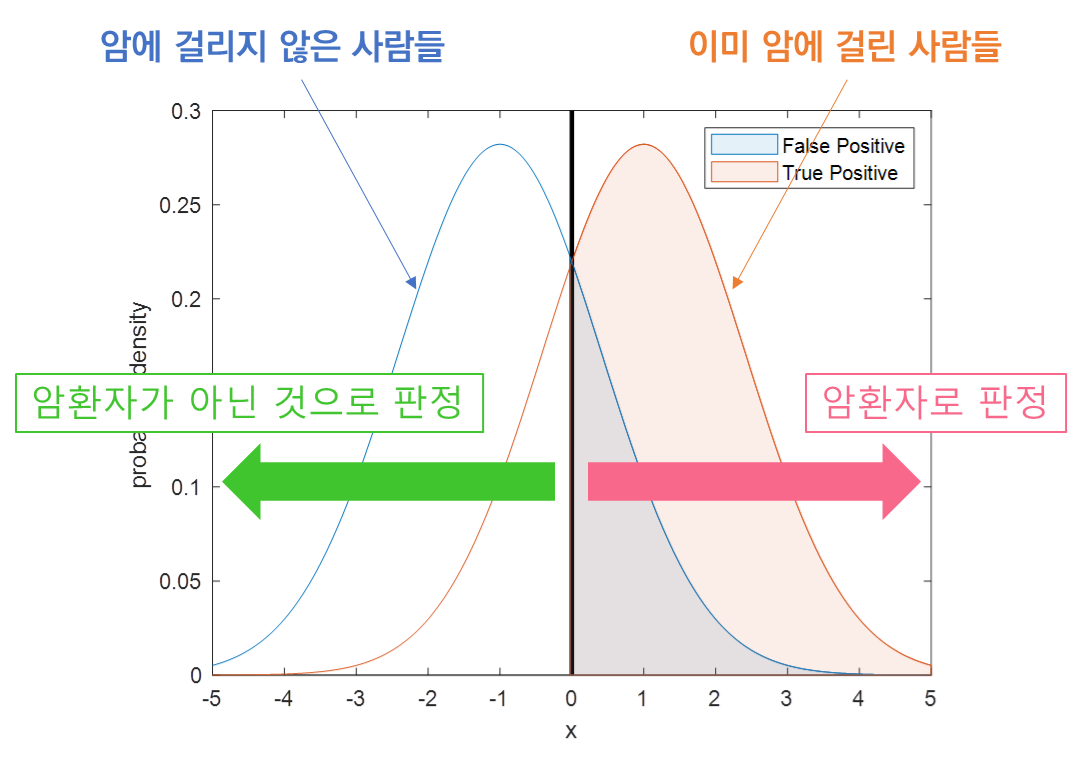

TPR, FPR → Positive 판단에 따른 성공, 실패 여부

- True Positive Ratio(=Recall) : $\frac{TP}{TP+FN}$

- 실제 Positive(양성)을 얼마나 정확히 분류 했는지

- False Positive Ratio(=Fallout) : $\frac{FP}{TN + FP}$시

- 실제 Negative(음성) 중 잘못 분류한 비율

- TPR, FPR 모두 Positive(양성) 판단에 따른 성공, 실패 여부를 다룸

- 이때 성공-실패 여부는 Positive(양성) 판단의 기준이 될 Threshold를 어떻게 설정 하느냐에 따라 다른 결과가 나오게 됨

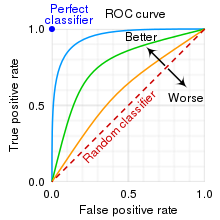

ROC와 AUC?

- ROC : Positive 예측 시 Threshold 별 양상을 확인하기 위해, FPR을 x 축으로, TPR을 y 축으로 설정한 Graph

- ROC Curve가 좌 상단에 붙어있을 수록 좋은 이진 분류기

- TP, FP 분포가 덜 겹침 → 정확한 분류가 이뤄짐

- AUC : Area Under the ROC Curve

- 문자 그대로 ROC Graph의 면적을 나타내는 값으로 0.5 ~ 1 사이의 값을 가진다.

참고

ROC curve - 공돌이의 수학정리노트

angeloyeo.github.io